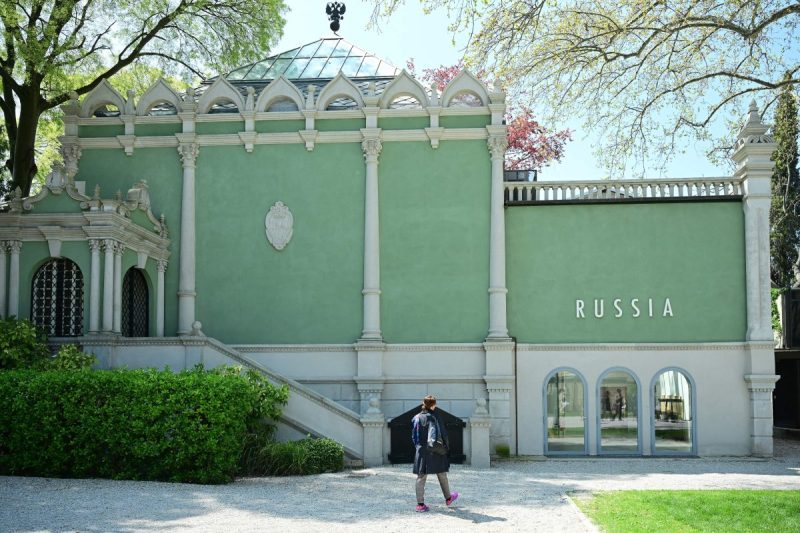

Quasi tutti Paesi europei si sono espressi contro la decisione della Biennale e in tanti hanno già iniziato a minacciare il boicottaggio.

L’altra faccia delle macchine

Intervista a Trevor Paglen, l’artista-ricercatore che con Kate Crawford ha raccolto le immagini con cui istruiamo l’intelligenza artificiale, in mostra all'Osservatorio Fondazione Prada.

«Quando leggiamo la realtà, un background suggerisce l’attribuzione di un senso o di un altro», spiega Trevor Paglen, artista e ricercatore americano che muovendosi tra creazioni di immagini, fotografia, geografia e giornalismo investigativo, ha sollevato il velo su porzioni di realtà che altrimenti sarebbero rimaste inesplorate, osservato i meccanismi che regolano il web, denunciato i rischi della digital surveillance, e ora guarda alle falle e zone d’ombra lasciate dall’intelligenza artificiale. Che si tratti di medium tecnologici o paradigmi di significati, la ricerca di Paglen ha a che vedere con l’urgenza di decodificare il presente. «Non è possibile adottare una prospettiva neutrale», continua l’artista. «In relazione alla computer vision e ai sistemi di intelligenza artificiale accade qualcosa di simile: quali sono le cornici storico-sociali utilizzate per interpretare le immagini raccolte e utilizzate al fine di addestrare le macchine a vedere gli esseri umani? È una domanda politica, non scientifica».

L’interrogativo è il punto di partenza di una mostra, ideata da Paglen insieme alla ricercatrice e co-fondatrice dell’AI Now Institute di New York Kate Crawford: Training Humans, all’Osservatorio Fondazione Prada dal 12 settembre 2019 al 24 febbraio 2020. «Le immagini che abbiamo deciso di mostrare sono viste di solito unicamente da macchine. È interessante pensare che l’occhio umano possa avere accesso a un simile archivio». Per la prima volta un’esposizione raccoglie set di training per la visione computerizzata. «Il nostro obiettivo era rendere note dinamiche poco conosciute. Volevamo guardare dentro il sistema dell’intelligenza artificiale, mostrare come visi e comportamenti umani siano raccontati e quali giudizi alcune categorie implicano».

Nessuna narrazione distopica o ultime frontiere robotiche, la ricerca di Paglen riflette sull’aspetto reale, materiale dell’AI. E sullo status dell’immagine nell’era odierna. Se lo storico e critico dell’arte James Elkins, a metà anni Novanta, ha analizzato le immagini non appartenenti alla categoria delle belle arti individuando correlazioni tra segni grafici, stili e schemi, a trent’anni dall’invenzione del World Wide Web (e molti di più dai primi esperimenti di riconoscimento facciale avanzati nei Sessanta), un altro settore che interessa la cultura visuale oggi viene alla luce. Un archivio fatto solo per le macchine. È stato utilizzato per perfezionare l’AI? «Non utilizzerei il termine perfezionare», precisa Paglen, «il verbo “perfezionare” presuppone una verità da raggiungere che invece non esiste, credo che si possa trovare una verità solo se questo sottende qualcosa che è stato deciso a priori attraverso le cornici di riferimento».

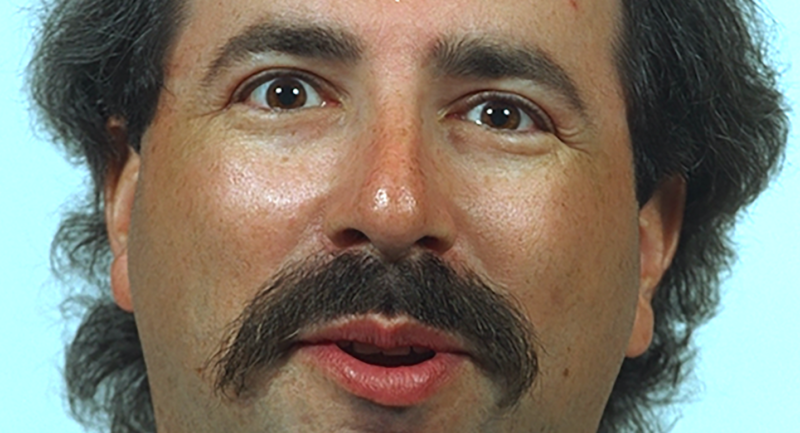

Tutte le immagini di quest’articolo sono tratte da: FERET Dataset, 1993-1996, National Institute of Standards. Un set di dati finanziato dal programma militare per le tecnologie antidroga degli Stati Uniti e impiegato negli studi sul riconoscimento facciale

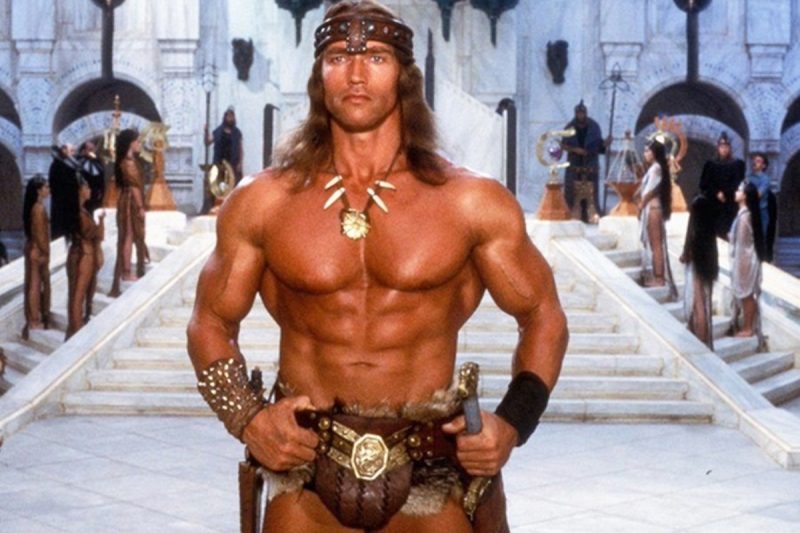

Quasi a indicare una via all’osservatore per addentrarsi in una materia complessa, la mostra si sviluppa su una base cronologica. Lo spartiacque è tra anni Novanta e Duemila. «Il mutamento più grande corrisponde alla diffusione dei social media. Il cambiamento è radicale per più di un motivo: il numero di immagini a disposizione è diventato di gran lunga maggiore, passando da centinaia a migliaia, il secondo aspetto riguarda la varietà di immagini che si possono reperire, il terzo riguarda il modo in cui sono etichettate». Tra le fonti dell’era pre-digitale, in mostra ci sono training set che utilizzano ritratti di celebrità perché facilmente reperibili prima che la marea di ritratti e selfie immessa quotidianamente nel web fosse la materia prima per allenare l’occhio delle macchine, e persino foto segnaletiche utilizzate senza che nessuno abbia dato il consenso. «Per addestrare l’intelligenza artificiale a rilevare l’invecchiamento era necessario confrontare volti di diverse età. Così molti sistemi hanno utilizzato foto segnaletiche di persone che sono state arrestate più volte nell’arco della loro vita al fine di rilevare come i loro visi fossero cambiati, di volta in volta, a ogni arresto».

Nell’era in cui il miracolo dell’AI sembra essere plasmato a uso e consumo della collettività, Paglen osserva cosa si nasconde dietro l’apparente rigore scientifico e alla neutralità di giudizio che i meccanismi di addestramento dell’AI hanno innescato, ultimo passo di una lunga ricerca. «L’intelligenza artificiale è politica», afferma Paglen, «è politica perché ogni volta che si etichettano visi, non si tratta di un lavoro di ricerca scientifica ma di un esperimento sociale. Quando pensiamo all’intelligenza artificiale ci immaginiamo qualcosa di neutrale, asettico, rigoroso. E non è assolutamente realistico».

Le immagini che abbiamo deciso di mostrare sono viste di solito unicamente da macchine. È interessante pensare che l’occhio umano possa avere accesso a un simile archivio

Nonostante l’AI sia spesso presentata come avanguardistica opportunità, quello che osserva è frutto di indicazioni che rispecchiano approssimazioni, interpretazioni erronee, pregiudizi e discriminazioni. «Il modo in cui gli esseri umani sono “etichettati” ha a che vedere con l’attribuzione di caratteri imprecisa, il patriarcato, il suprematismo bianco. È quello che ho cercato di denunciare attraverso la mostra». Un esempio su tutti è rintracciabile tra le maglie di ImageNet, una collezione di immagini pubblicata nel 2009 dai ricercatori delle università di Stanford e Princeton, descritta dai fondatori come il tentativo di «mappare l’intero universo di oggetti».

Tra le 20.000 categorie, 2.000 sono dedicate agli esseri umani. A guardarle con attenzione emergono classificazioni classiste sulla base della professione e persino etichette misogine o razziste. Le più allarmanti discriminazioni riguardano il modo in cui genere ed etnia sono percepiti dalle macchine. «I volti sono etichettati. Ed è comune nei training set che il genere sia visto come binario. Uomo o donna. Qui risiede un esempio di giudizio politico mascherato dalla presunta obiettività scientifica. Il genere non è binario ma le macchine non sembrano registrarlo». E non è questo l’unico caso in cui l’assenza di diversità è un dato preoccupante. «In modo analogo accade per l’etnia. Si tratta di un concetto complesso che ingloba implicazioni socio-culturali. Ma anche qui le possibilità dell’AI mostrano una disarmante semplificazione: white, black, asiatico, indiano o altro. L’idea che possiamo includere background complessi e diversificati in questa manciata di opzioni sembra impossibile. L’interpretazione è inesatta, ancorata a giudizi retrogradi e pregna di stereotipi».

Guardando il problema da una prospettiva storica e antropologica quali sono i rischi nell’instillare il seme di categorie e suddivisioni di questo tipo? «Quando osserviamo classificazioni pensiamo a comparazioni, altri contesti in cui gli esseri umani sono stati etichettati in questo modo. Torna inevitabilmente alla memoria il periodo dell’Apartheid in Sud Africa. Il paragone serve a dimostrare che un pensiero o un giudizio razzista lo è indipendentemente se è formulato da esseri umani o sistemi computerizzati». Un altro punto cardine della questione che riguarda lo sviluppo dell’AI è l’appropriazione di materiale vernacolare per creare i training set destinati alle macchine. Scatti privati, selfie, immagini amatoriali sono utilizzati per l’identificazione e il riconoscimento di modelli computerizzati.

Ecco la “machine vernacular”. «Così indichiamo le immagini postate o caricate online, scaricate e utilizzate senza il consenso degli interessati. Quando osserviamo i training data, specialmente quelli contemporanei, capiamo che la maggior parte di essi è stata costruita navigando in internet e salvando migliaia di scatti che ogni giorno vengono immessi». La domanda è inevitabile: com’è stato possibile? «C’è una ragione legata ai processi tecnologici. Se si pensa alla semplicità con cui reperire e riunire una grande quantità di materiale fotografico si pensa subito al web. E gli ingegneri informatici hanno introiettato questa possibilità. Ma c’è anche una risposta al quesito che riguarda aspetti etici insiti nell’utilizzare immagini trovate. Non c’è nessuna regolamentazione che lo possa impedire e il fatto che sia legale solleva non pochi interrogativi. Nonostante questo, ogni giorno viene etichettato e archiviato un numero elevatissimo di materiale a uso e consumo delle macchine».

Se a preoccupare gli utenti sono perlopiù questioni legate alla privacy, per Paglen il problema è una complessa catena di fattori che va letta sul piano globale. «Non penso alla privacy, penso più alle conseguenze che riguardano l’intera società, ma non il singolo individuo, penso a come il largo utilizzo di sistemi di questo tipo stia cambiando le dinamiche collettive e abbia un ruolo lesivo sull’autonomia e sull’autodeterminazione». Lo sfruttamento del materiale di questo tipo a fini commerciali e la vendita dei dati è materia nota, meno trasparenti sono invece i legami con istituzioni governative e militari. «Dobbiamo tenere a mente la distinzione tra uso governativo delle immagini e uso commerciale. Se guardiamo a Facebook ad esempio, probabilmente il più grande archivio di visi “etichettati” attraverso tag al mondo che può essere utilizzato per il riconoscimento facciale, l’uso commerciale delle immagini è quello che più facilmente emerge. Tuttavia l’archivio è accessibile anche a organismi militari o governativi. E non è esclusa la possibilità di un utilizzo da parte di governi, tutt’altro. È difficile tracciare una linea netta tra l’uso commerciale e quello politico».

In un contesto di questo tipo dati immessi in rete, fotografie di famiglia o delle vacanze, selfie compresi, sono elementi fondamentali nel sistema politico ed economico internazionale. «Oggi il capitalismo affonda le radici nell’appropriazione di uno spazio un tempo pubblico e libero come il web, lo ingloba in un sistema di mercato e tocca ambiti prima ritenuti immuni a tutto ciò. Dettagli, informazioni e immagini appartenenti alla sfera privata diventano tasselli di questo sistema. A discapito della libertà individuale e collettiva».

Un set speciale e segreto che ora, nel giorno dell'anniversario della morte del fondatore, si può ascoltare e scaricare gratuitamente sulla pagina Bandcamp di C2C Festival.

Lo scrittore ha recentemente ribadito che «non è dell'umore giusto» per scrivere il finale, gettando nello sconforto chi da anni lo attende. Ma il tormentato rapporto con la sua opera più famosa dice molto su cosa significhi oggi essere uno scrittore di successo.