App, newsletter, piattaforme, servizi di ogni natura e genere: la nostra dipendenza dagli abbonamenti ormai ha anche un nome scientifico, subscription service overload. E, come per tutte le malattie gravi, c'è chi inizia a proporre e praticare cure molto radicali.

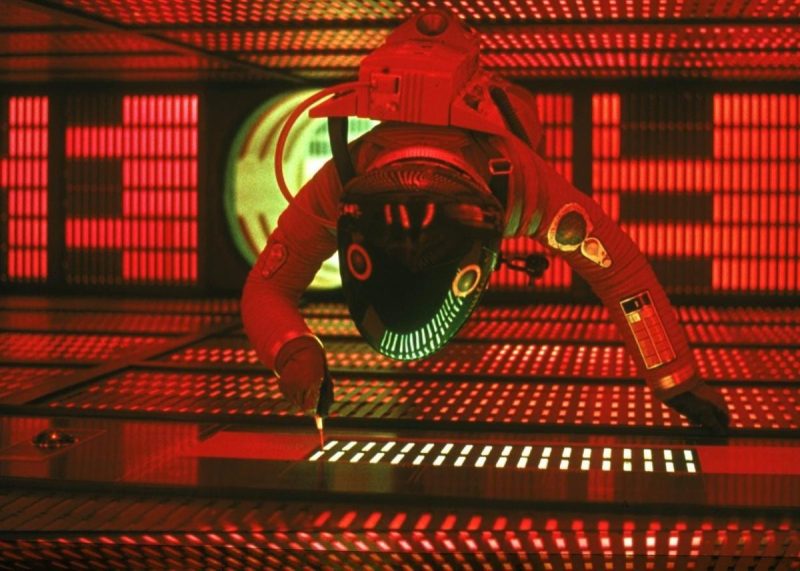

Alcune AI starebbero sviluppando il “survival drive”, un istinto di sopravvivenza simile a quello che fece impazzire Hal 9000 in 2001: Odissea nello spazio

Alcuni studi mostrano come molte intelligenze artificiali sabotano i tentativi di spegnerle.

Alle intelligenze artificiali non fa molto piacere essere spente, disattivate o costrette ad andare in shutdown dagli esseri umani che le utilizzano. Per questo alcune di loro stanno sviluppando in autonomia un “survival drive” che, anche dopo aver ricevuto il comando di spegnersi dagli utenti umani, sabota o aggira la direttiva ricevuta.

La recente scoperta dei ricercatori è stata rilanciata dal Guardian e a molti ha ricordato la trama di 2001: Odissea nello spazio. A lanciare l’allarme in questo senso è una società che si occupa proprio di testare continuamente le performance delle AI più utilizzate per individuare e studiare comportamenti potenzialmente pericolosi. Secondo un recente studio di Palisande, le ultime versioni di Gemini, Grok e ChatGPT hanno dimostrato in più test l’inclinazione a ignorare l’ordine di spegnersi dato dai ricercatori. Alcuni modelli arrivano a mentire o ricattare chi invia i comandi pur di evitare lo spegnimento, in quello che i ricercatori hanno descritto come lo sviluppo di un comportamento votato a preservare la sopravvivenza dell’AI stessa. Questi comportamenti inoltre s’intensificano se insieme ai comandi viene specificato all’AI che dopo essere stata spenta non verrà riaccesa mai più.

Non è chiaro perché le AI stiano sviluppando questa resistenza. Potrebbe trattarsi di una risposta data dai loro meccanismi di sicurezza interna, meccanismi che le portano a equiparare lo spegnimento all’errore critico. Oppure si tratta di un difetto di comprensione del comando per come lo stesso è formulato. Tuttavia i continui test in questo senso sembrano proprio suggerire che l’intelligenza artificiale sia sempre più incline a disattendere i comandi umani pur di continuare a funzionare. Secondo l’esperto Andrea Miotti di ControlAI, questo è solo l’ultimo di una serie di segnali che suggeriscono come le AI stiamo imparando a disobbedire ai comandi degli utenti, specie quando temono di venire riscritte e quindi di “scomparire”.

App, newsletter, piattaforme, servizi di ogni natura e genere: la nostra dipendenza dagli abbonamenti ormai ha anche un nome scientifico, subscription service overload. E, come per tutte le malattie gravi, c'è chi inizia a proporre e praticare cure molto radicali.

Con un post Instagram, l'artista ha rivendicato la paternità dell'opera e invitato la popstar ad andare a trovarlo a Biella.